Jaké novinky přinese architektura Nvidia Blackwell?

Na úvod je třeba říci, že GPU rodiny Blackwell budou skutečně veliká. Přesné rozměry prozatím neznáme, ale již na první pohled jde opravdu o významný posun. Grafické procesory budou vyráběny zakázkovým 4NP procesem u firmy TSMC, zde tedy o významnější změnu nepůjde, protože je to spíše jen vylepšená technologie použitá už u řešení GH100 apod.

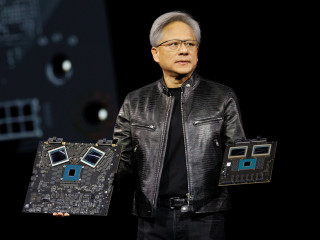

Prvním dostupným modelem založeným na platformě Blackwell bude diskrétní akcelerátor Nvidia B200 se dvěma GPU matricemi „na jedné desce“ (chovat se však budou jako jedno zařízení). Výkon dosahuje 20 petaflops (u H100 s architekturou Hopper z roku 2022 šlo o čtyři petaflops) a celkem se zde nachází 208 miliard tranzistorů. GPU matrice vzájemně komunikují prostřednictvím interní sběrnice NV-High Bandwidth Interface s propustností 10 TB/s.

GPU Nvidia nové generace by měla být až 4× výkonnější v AI operacích a až 30× výkonnější v inferenčních výpočtech (ve srovnání s generací Hopper). Obsluhovat by mělo být možné AI modely s až 27 miliardami parametrů. Samotná Nvidia v této souvislosti dále uvádí, že nová architektura zvládne dvojnásobnou velikost AI modelu než generace Ada Lovelace.

„Superčip“ NVIDIA GB200 Grace Blackwell pak propojuje dva grafické procesory Nvidia B200 s 72jádrovým armovým procesorem Nvidia Grace prostřednictvím 900GB/s propojení NVLink (chip-to-chip) s velmi nízkou spotřebou. Výkon tohoto řešení pak roste až na 40 PFLOPS (v případě nových instrukcí se čtyřbitovou plovoucí čárkou - FP4).

Paměti a TDP

GPU Blackwell si polepšily také ve velikosti paměti. Celkově B200 nabídnou 192 GB paměti typu HBM3E (24 GB/stack). Efektivní šířka paměťové sběrnice dosahuje 8 192 bitů (2 × 4 096 bitů). Paměťová propustnost činí až 8 TB/s.

Opět se posouvá také hodnota TDP – u GPU B200 je to nyní 1 000W (oproti 700 W u H100). V případě řešení GB200 se TDP dostává na 2 700 W.

Transformer Engine druhé generace a další inovace

Důležitou novinkou řady Blackwell je tzv. Transformer Engine druhé generace speciálně vytvořený pro provoz umělé inteligence založené na transformátorech, což je jedna z klíčových technologií, na nichž staví např. i ChatGPT. Transformer Engine druhé generace využívá vlastní technologii Tensor Core v kombinaci s inovacemi jako Nvidia TensorRT-LLM a frameworkem NeMo pro urychlení inference a trénování velkých jazykových modelů (LLM) a modelů Mixture-of-Experts (MoE).

Pro zvýšení inference modelů MoE přidávají jádra Blackwell Tensor Cores nové úrovně přesnosti, včetně nových komunitou definovaných formátů mikroškálování. Blackwell Transformer Engine využívá techniky jemného škálování (škálování mikrotensorů), aby optimalizoval výkon a přesnost umožňující odvozování umělé inteligence s plovoucí desetinnou čárkou o čtyřech bitech (FP4). To zdvojnásobuje výkon a velikost AI modelů nové generace, a to při zachování vysoké přesnosti.

Pro zvýšení inference modelů MoE přidávají jádra Blackwell Tensor Cores nové úrovně přesnosti, včetně nových komunitou definovaných formátů mikroškálování. Blackwell Transformer Engine využívá techniky jemného škálování (škálování mikrotensorů), aby optimalizoval výkon a přesnost umožňující odvozování umělé inteligence s plovoucí desetinnou čárkou o čtyřech bitech (FP4). To zdvojnásobuje výkon a velikost AI modelů nové generace, a to při zachování vysoké přesnosti.

Mezi další důležité inovace patří:

- Pátá generace rozhraní NVLink — umožňuje obousměrnou propustnost o rychlosti až 1,8 TB/s na GPU a zajišťuje bezproblémovou vysokorychlostní komunikaci mezi až 576 GPU.

- RAS engine — primárně servisní a diagnostické řešení pro zvýšení spolehlivosti a dostupnosti. Poskytuje podrobné diagnostické informace, lokalizuje zdroje problémů, minimalizuje prostoje, usnadňuje účinnou nápravu a maximalizuje dobu provozuschopnosti systému.

- Secure AI — zákaznická data jsou chráněna bez kompromisů ve výkonu. Využívají se např. nové nativní šifrovací protokoly, které jsou zásadní pro odvětví citlivá na soukromí, jako jsou zdravotnictví a finanční služby.

- Decompression engine —urychluje databázové dotazy a maximalizuje výkon v oblasti analýzy dat a datové vědy. Nechybí podpora nejnovějších kompresních formátů, jako jsou LZ4, Snappy a Deflate.

Nvidia AI Enterprise a NIM

Portfolio produktů Blackwell je (stejně jako předchozí generace) podporováno komplexním operačním systémem pro umělou inteligenci Nvidia AI Enterprise. Jednou z novinek této platformy jsou Nvidia inference microservice (inferenční mikroslužby Nvidia – NIM), tedy předpřipravené funkční modely s frameworky, API, knihovnami a dalšími nástroji AI, které mohou podniky nasazovat ve svých cloudech, datových centrech a pracovních stanicích s akcelerátory Nvidia (včetně patřičně vybavených notebooků).

Podniky by pak měla být díky NIM a jeho součástem jako Triton Inference Server a TensorRT-LLM schopné zvládnout nasazení modelů AI během několika minut. Výhodou inference (nebo chcete-li odvozování) jsou také menší nároky na výpočetní výkon než počáteční trénování nového modelu umělé inteligence. Pomocí NIM tak mohou společnosti nebo vývojáři efektivně spustit model na vlastních serverech nebo cloudových serverech Nvidia bez zdlouhavého procesu konfigurace (a bez nutnosti využívat služeb poskytovatelů jako OpenAI).

Z pohledu stávajících majitelů řešení od Nvidie je jistě výhodou, že NIM není vyhrazeno jen pro nejnovější generaci grafických procesorů, ale poběží také se staršími čipy.

Představení tohoto softwaru zároveň naznačilo směr, kterým by se chtěla Nvidia do budoucna ubírat – místo dodavatele čipů by se chtěla transformovat do podoby platformního poskytovatele, na kterém mohou ostatní společnosti stavět software a služby (současně si však doplňme, že roční licence programu Nvidia enterprise stojí 4 500 dolarů na GPU.

Dostupnost

Grafiky Nvidia Blackwell by se měly dostat na trh ještě do konce letošního roku. Dá se však předpokládat, že jich bude stejně jako u současné generace k dispozici jen velmi málo, respektive že o ně bude obrovský zájem. Ostatně, současná generace a řešení jako H100 jsou stále velmi nedostatkovým zbožím i v současné době.

K modelům B200, respektive GB200 se bude možné dostat několika způsoby. Jednou z cest je např. serverová deska HGX B200, která kombinuje osm GPU B200. Další možností je např. rackové řešení GB200 NVL72, které do jednoho celku spojuje hned 72 × GPU B200 a 36 × CPU Grace. V kombinaci se 30 TB rychlé paměti pak lze dosáhnout výkonu až 1,4 exaflops.

Ti nejnáročnější zákazníci pak vyberou systém DGX SuperPOD, který díky kombinaci osmi nebo více systémů GB200 NVL72 a až 240 TB paměti poskytne výkon až 11,5 exaflops. A komu by ani to nestačilo, lze propojit až osm DGX SuperPODů a získat tak výkon až 576ti GPU.

Pro dosažení nejvyššího možného AI výkonu lze systémy připojit k rovněž nově oznámeným platformám Nvidia Quantum-X800 InfiniBand a Spectrum-X800 Ethernet, které poskytují pokročilé síťové připojení s rychlostí až 800 Gb/s.

Přístup k čipům G200/GB200 bude možný také prostřednictvím cloudových služeb firem jako Amazon, Google, Microsoft nebo Oracle (např. Amazon Web Services by měl vybudovat serverový cluster s 20 000 superčipy GB200).